IA que sí vale para crear contenido

Ayer estaba probando una herramienta que se supone que está preparada para generar miniaturas con inteligencia artificial y era una basura.

En plan, menuda estafa: treinta euros al mes por una herramienta que no deja de ser un midjourney al que se le ha fijado una resolución de miniaturas por defecto.

No consigo acertar la miniatura de mi último vídeo y estuve haciendo pruebas. ESTE ES EL RESULTADO:

Que sí, que ya lo sé, que algunos sois ingenieros de prompting y que el problema es mío que no se hablar con la IA.

En fin, para los que sois como yo y creéis que la gente se flipa mucho con estas herramientas de IA, hoy os voy a enseñar dos herramientas que sí sirven para crear contenido.

Estos son ElevenLabs y HeyGen.

Lo primero que he hecho es coger una serie de planos que tenía de un antiguo vídeo y meterlo en HeyGen. Lo único que hace falta es un vídeo mirando a cámara de entre 2 y 6 minutos. Cuanto menos te muevas mejor. Yo, por suerte, tenía una plano donde no salen mis manos. Así creo que es más fácil para la IA.

Este es el resultado.

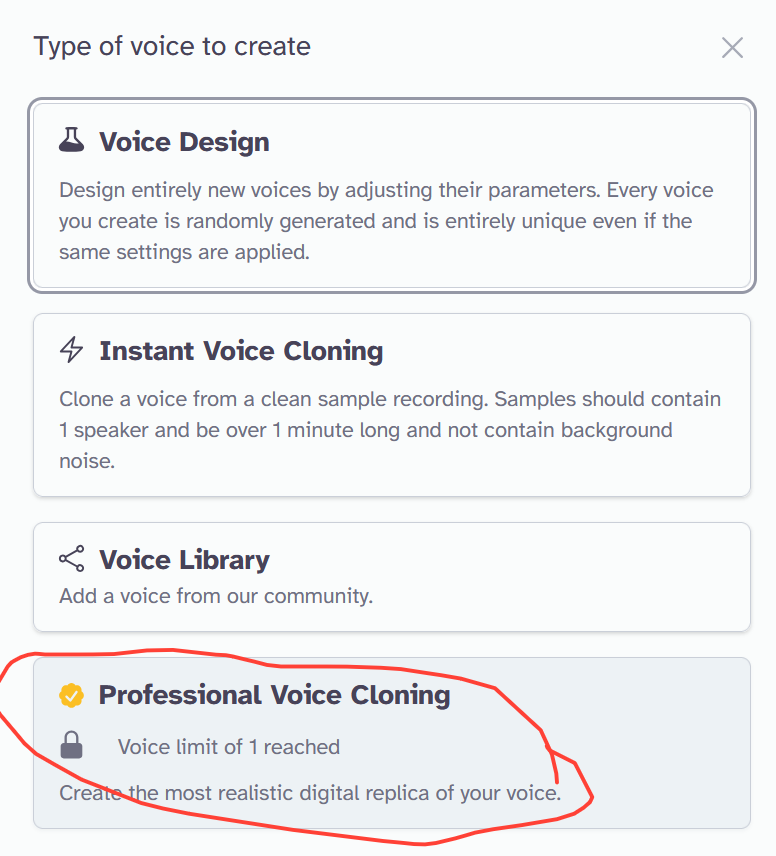

Como veis, también ha clonado mi voz, pero de una forma muy cutre. Entonces he utilizado el clonador de voz de ElevenLabs, pero no el "instant cloning", sino el "Professional voice cloning". El que hay que pagar, vamos.

Para eso he juntado las locuciones de mis anteriores vídeos y las he juntado en un audio de cuatro horas y media. Después de eso la herramienta ha estado unas 24 horas entrenando el modelo y este es el resultado.

A que es flipante, jajaja

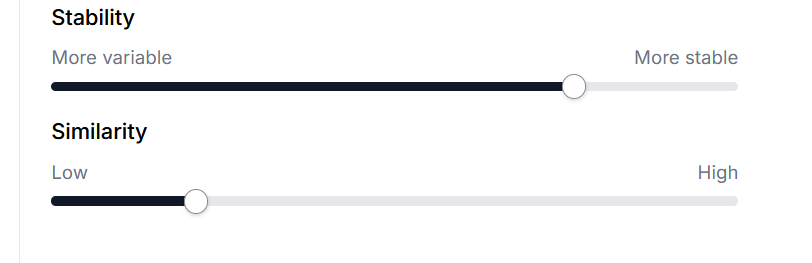

A veces noto que le falla un poco el ritmo, y aunque hay un par de variables que puedes ir tocando, no termino de encontrar el punto perfecto.

Por ahora en esos valores es donde mejor resultado estoy obteniendo. Ya os digo, tanto HeyGen como ElevenLabs están lejos de ser perfectos, pero como herramienta de creación de contenido los veo mucho más afilados que otras de generación de imágenes y generación de vídeos.

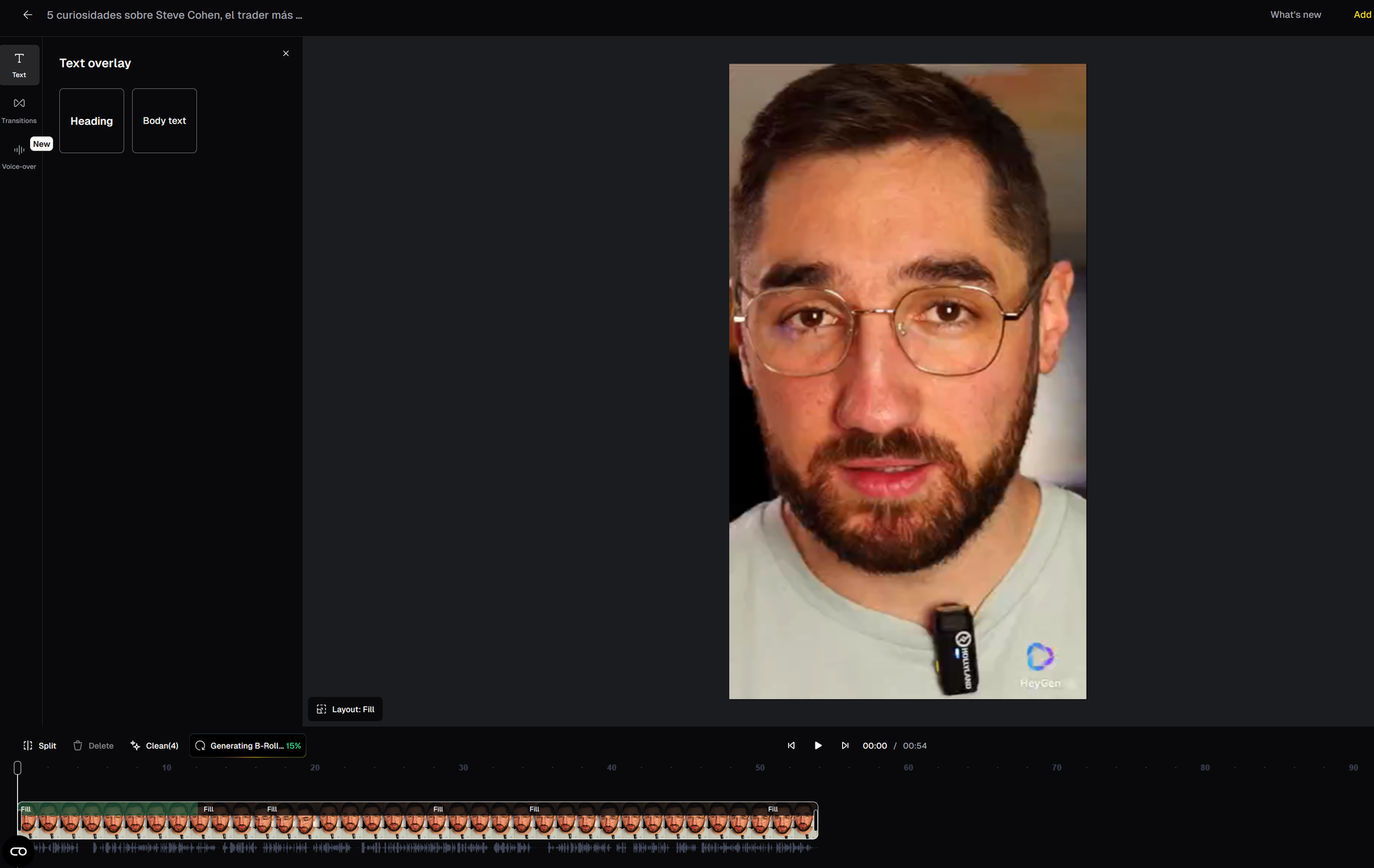

Pero vamos a seguir mejorando el contenido. Ahora le he pedido a ChatGPT que me escriba un guion sobre Steve Cohen, lo he pasado por ElevenLabs, luego por HeyGen, y este es el resultado:

En este caso se le ven las costuras a HeyGen en un aspecto: cuando la locución va a un ritmo alto trabaja muy bien, pero cuando hay pausas el avatar se descontrola. Hace movimientos de NPC total. Eso habría que curarlo.

Pero un momento que todavía me queda un as en la manga. Vamos a pasarlo por Opusclip, que tiene una opción llamada "aumatic B-Roll". Esto lo que hace es intercalar imágenes generadas por IA en el vídeo. También le vamos a añadir subtítulos con Opusclip, que aunque sea una chorrada, yo creo que distrae a la gente de los fallos del avatar de HeyGen.

Al final este es el resultado:

Bueno, el resultado todavía deja mucho que desear y requiere de edición humana.

Como curiosidad, he cometido dos errores en el entreno de estas herramientas:

- Para generar el avatar, le he dado a HeyGen un vídeo donde en un momento dado apartaba los ojos de la cámara para leer el guion. También había cortes. Por eso ahora mi avatar a veces lee el guion y tiene cortes. Para hacer las cosas bien hay que grabar durante unos cinco minutos hablando a cámara sin apartar la mirada.

- En la clonación de voz he metido horas y horas de mi locución pero se trata de una locución bruta, donde me equivoco y repito la misma frase más de una vez. Ahora el maldito elevenlabs también se equivoca y creo que puede deberse a entrenar el modelo con un contenido un poco chapucero.

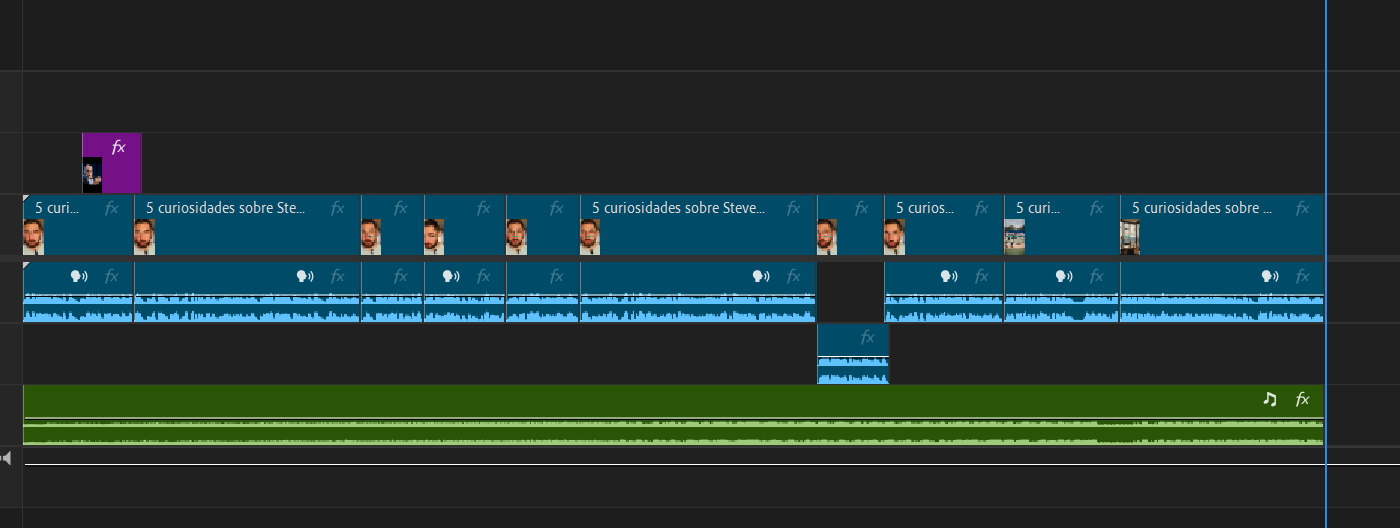

Yo pienso volver a clonar la voz y volver a hacer un avatar solucionando estos errores. Creo que si juntas IA con trabajo manual puedes llegar a tener unos resultados interesantes. Mirad, haciendo unos cortes para quitar el error de NPC, añadiendo música y una foto de Steve Cohen, este es el resultado.

Por cierto en este clip de HeyGen se me quedó marca de agua pero debe de ser un bug. El precio es de unos treinta euros y con eso tienes 1080p sin marca de agua.

En fin, este experimento ya me hace creer un poco más en las posibilidades de la IA. Evidentemente no creo que este tipo de contenido vaya a tener gran recorrido, pero me imagino poder meter clips de mi avatar en un momento en el que estoy fuera de mi Setup y no tengo donde poder grabarme un buen plano.

El B-roll de OpusClip me parece que no da la talla.

Y la clonación de voz de Elevenlabs todavía tiene que mejorar, pero ya empieza a sonar bastante bien.

Habrá que estar atento a las tendencias.

Feliz semana!